Wenn über KI gesprochen wird, ist der Terminus »Neuronale Netze« nicht weit.

Was aber sind »Neuronale Netze«, welche Unterschiede gibt es und was tun sie eigentlich?

Ich freue mich über den Gastbeitrag von Nico Beck, Experte im ADA Lovelace Center in der Applikation Neuronale Netzwerke für optimierte Zeitreihenprognosen.

Was sind Neuronale Netze?

Neuronale Netze sind mathematische Funktionen mit sehr vielen Parametern. Diese Parameter werden in einer Trainingsphase so angepasst, dass das Modell komplexe Zusammenhänge zwischen Daten und einer oder sogar mehreren Zielvariablen darstellen kann.

Diese Zielvariable kann verschiedene Formen haben. Beispielsweise können damit Daten in vorgegebene Kategorien klassifiziert werden – so können Neuronale Netze dahingehend modelliert werden, dass sie Bilder von Katzen und Hunden voneinander unterscheiden können. Eine weitere Möglichkeit besteht darin Neuronale Netze so anzupassen, dass sie Werte prognostizieren. Ein Beispiel ist die Prognose der Weinqualität anhand von Messwerten wie Restsüße und pH-Wert des Weins.

Verschiedene Arten von Neuronalen Netzen

Die Art der Daten entscheidet welche Art von Neuronalen Netz verwendet wird und die Prognose oder Klassifikation basiert immer auf Daten. Bei Bildern werden meist Convolutional Neural Network verwendet. Sie sind gut dafür geeignet Nachbarschaftsbeziehungen zu modellieren. Bei Bildern bedeutet das, dass Strukturen wie Linien oder Kreise in benachbarten Pixeln erkannt werden können.

Falls keine Nachbarschaftsbeziehungen vorhanden sind und es keine Rolle spielt in welcher Reihenfolge die Daten dem Neuronalen Netz übergeben werden, können Feed-Forward-Neural Networks verwendet werden. Im Gegensatz zu Pixeln in einem Bild, können Restsüße und pH-Wert des Weines in dem Modell ohne Konsequenzen getauscht werden.

Außerdem gibt es die Recurrent Neural Networks. Sie können sehr gut für Zeitreihenprognosen verwendet werden, da sie für jeden Zeitpunkt einen Zustand berechnen. Der vorherige Zustand wird für die Berechnung des nächsten Zustandes verwendet und so sind sie in der Lage zeitliche Beziehungen in Zeitreihen zu modellieren.

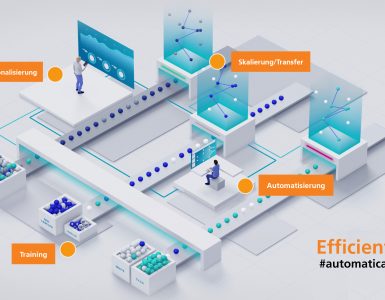

Recurrent Neural Networks in der Anwendung

Die Möglichkeit, zeitliche Beziehungen zu modellieren, macht die Methodik interessant für viele Anwendungen. Ich beschäftige mich in meiner Applikation beispielsweise damit, wie Recurrent Neural Networks für die Prognose von Rohstoffpreisen verwendet werden können.

Auf Grundlage der Prognose soll der Einkaufszeitpunkt im Handel verbessert werden, um die Einkaufspreise zu reduzieren. Im makroökonomischen Markt gibt es viele Zeitreihen, die sich gegenseitig beeinflussen. Zum Beispiel hängt der Stahlpreis stark vom Eisenerzpreis ab. Verändert sich der Preis, die Nachfrage oder das Angebot des Einen, hat dies einen direkten Einfluss auf den anderen und umgekehrt. Diese Zusammenhänge werden für alle relevanten Zeitreihen schnell komplex und sind für Menschen kaum zu überblicken. Für diesen Anwendungsfall hat Hans Georg Zimmermann ein Recurrent Neural Network mit einer speziellen Architektur entwickelt – das Historical Consistent Neural Network. Das Modell lernt eine interne Darstellung der relevanten Zeitreihen und prognostiziert diese zusammen für zukünftige Schritte. Dadurch können die komplexen Zusammenhänge zwischen den Zeitreihen in Vergangenheit und Zukunft unverändert modelliert werden, was die Prognose verbessert. In meiner Forschung untersuche ich wie das Modell weiterentwickelt und bestmöglich zur Rohstoffpreisprognose verwendet werden kann.

Applications in more detail: Neural Networks

When people talk about Kl, the term „Neural Networks“ is often used. But what are „Neural Networks“, what are the differences and what do they actually do? I am pleased to have the guest contribution of Nico Beck, an expert at ADA Lovelace Center in the application Neural Networks for optimized time series forecasting.

What are Neural Networks?

Neural networks are mathematical functions with many parameters. These parameters are adjusted in a represent complex relationships between data and one or even more target variables. This target variable can have various forms. For example, it can be used to classify data into given categories – so neural networks can be modelled to distinguish images of cats and dogs. Another possibility is to adapt neural networks, so that they predict values. An example is the prediction of wine quality based on measured values such as residual sweetness and pH value of the wine.

Different types of Neural Networks

The type of data decides which type of neural networks is used and prediction or classification is always based on data. For images, Convolutional Neural Networks are mostly used. They are good for modelling neighbourhood relationships. For images, this means that structures such as lines or circles in neighbouring pixels can be recognized.

If there are no neighbourhood relations and if it does matter in which order the data is passed to the neutral network, feed forward neural networks can be used. In contrast to pixels in an image, residual sweetness and pH value of the wine can be swapped in the model without consequences.

Furthermore, there are Recurrent Neural Networks. They can be used very well for time. The previous state is used for the calculation of the next state and so they are able to model temporal relationships in time series.

Recurrent Neural Networks in Application

The ability to model temporal relationships makes the methodology interesting for many applications. For example, in my application I am looking at how Recurrent Neural Networks can be used to forecast commodity prices.

Based on the forecast, the purchase timing in trade should be improved to reduce the purchase prices. In the macroeconomic marked, there are many time series that influence each other. For example, the price of steel depends heavily on the price of iron ore. If the price, demand or supply of one changes, this has a direct impact on the other and vice versa. These interrelationships quickly become complex for all relevant time series and are hard for humans to keep track of. For this use case, Hans Georg Zimmermann has developed a Recurrent Neural Network with a special architecture – the Historical Consistent Neural Network. The model learns an internal representation of the relevant time series and predicts them together for future steps. This allows the complex relationships between past and future time series to be modelled unchanged, improving forecasting. In my research, I am investigating how the model can be further developed and best used for commodity price forecasting.